In unseren Themendossiers bündeln wir für dich ausgewählte Inhalte zu einem sorgfältig ausgewählten Themenschwerpunkt. Sie bieten dir einen umfassenden Zugang zu praxisnahen Ideen, Hintergrundwissen, Projekten und Impulsen – kompakt aufbereitet und aktuell.

Dieses Dossier widmet sich dem Thema KI in der Bildung – keine Frage des Ob, sondern des Wie. Hier geht’s zu den anderen Beiträgen.

Intro: Ausgangssituation

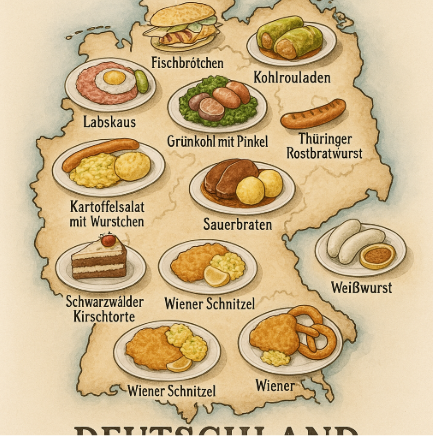

Ich habe ein KI-Tool gebeten, mir ein Bild zu generieren. Der Prompt lautete: „Erstelle mir eine Karte von Deutschland, auf der Zeichnungen der bekanntesten regionalen Speisen an den passenden Stellen in der Karte zu sehen sind.“

Das Ergebnis spricht für sich:

Solche und ähnliche fehlerhafte Ergebnisse von KI-Tools begegnen Nutzer:innen auch 2025 noch so zuverlässig, dass es eigene Webseiten und Foren gibt, die sich ausschließlich sogenannten „AI fails“ widmen.

Was wie hier oft unterhaltsam ist, stellt uns im Schulalltag jedoch vor ein Problem. Wie wählen wir das KI-Tool aus, welches uns optimal unterstützt?

Mit Bestenlisten auf der Suche nach dem KI-Tool #1

Wie Smartphones, E-Bikes oder Kaffeemaschinen werden auch KI-Modelle Vergleichstests (auch Benchmarks genannt) unterzogen. Diese Benchmarks, also feste Testprotokolle, in deren Rahmen das KI-Modell definierte Aufgaben bekommt und seine Leistungsfähigkeit bei deren Bearbeitung gemessen wird, sollen uns helfen, die Qualität des Large Language Models (LLM) und damit auch der auf dem LLM basierenden Anwendung abzuschätzen. Einige der bekanntesten Benchmarks sind GLUE, SuperGLUE, XGLUE oder auch BIG-Bench. Auch Websites wie huggingface.co, auf der viele quelloffene LLM vorgestellt werden, erstellen eigene Ranglisten. Diese basieren häufig auf einer Kombination verschiedener Benchmarks und zeigen sowohl bekannte als auch weniger bekannte Modelle.

Diese Benchmarks liefern eine erste Orientierung hinsichtlich der Leistungsfähigkeit der LLM, bringen aber auch eine Reihe neuer Herausforderungen mit sich. Viele der Tests basieren beispielsweise auf dem Turing-Test, den der Mathematiker Alan Turing ersonnen hat. Besonders erfolgreich sind hier in der Folge Modelle, die menschliches Verhalten imitieren. Ob sie für bestimmte Aufgaben besonders geeignet sind, lässt sich allerdings nicht unmittelbar absehen.

Perfekte Imitation des Menschen als Maxime?

Mit dem BIG-Bench wird versucht, diesem Problem zu begegnen und macht die Idee bereits im Namen deutlich: BIG ist ein Akronym und steht für „Beyond the Imitation Game“. Der Benchmark ist das Ergebnis einer Zusammenarbeit von etwa 400 Autor:innen, die Aufgaben aus verschiedenen Bereichen wie Mathematik, Commonsense, Linguistik und Logik entwickelt haben, um die Leistungsfähigkeit eines LLM in diversen, realistischen Szenarien zu messen.

Auch dieser Ansatz ist jedoch nicht unumstritten. Dadurch, dass der BIG-Bench in Quellcode und Aufgabenkatalog offen einsehbar ist, kann der Trainingsprozess eines LLMs gezielt für den Benchmark optimiert werden. Wir kennen die Strategie als ‚teaching to the test‘, wenn wir Schüler:innen gezielt Fragen in der anstehenden Leistungsstanderhebung vorbereiten. Wie tief ihr Wissen um ein Thema abseits der trainierten Fragen ist, bleibt dabei unter Umständen verborgen.

Speziallösungen

Mit dem Pioneers Program verfolgt OpenAI, das Unternehmen hinter ChatGPT, einen anderen Ansatz. Die Idee ist: spezialisierte, auf die Anforderungen konkreter Bereiche angepasste Benchmarks liefern bessere Ergebnisse und damit eine bessere Orientierung für konkrete Aufgaben. Das Programm befindet sich jedoch noch in einem frühen Stadium und ist nicht primär auf Schulen ausgerichtet.

Lasst die Nutzer:innen entscheiden

LMArena ist eine Plattform zum Vergleichen von KI-Sprachmodellen (LLMs) — aber auf eine interaktive und spielerische Weise. Statt wie bei einem Benchmark rein technische Tests durchzuführen (z. B. Grammatik, Logik oder Wissen zu prüfen), setzt LMArena auf das Urteil von Menschen. Dabei nimmt sich dieser Ansatz ein Vorbild am Amazon Marketplace, der als eines der ersten Angebote die Wirksamkeit von Nutzer:innenfeedback erkannt und mit den Produktbewertungen zu einem zentralen Element des Marktplatzes gemacht hat. Die Plattform ist folgendermaßen konzipiert: wenn Nutzer:innen wie bei einem konventionellen KI-Chatbot einen Prompt eingeben, werden ihnen zwei Vorschläge präsentiert, die von unterschiedlichen LLM generiert wurden. Erst, nachdem sie sich für ein Ergebnis entschieden haben, können sie sehen, welches LLM den jeweiligen Vorschlag erzeugt hat. Auf Basis dieser Blindbewertung erstellt die Plattform eine Rangliste der jeweiligen LLM.

Fazit: Die Kriterien der Güte

Ein gutes KI-Tool ist allerdings mehr als nur eine gute Platzierung in einem Benchmark-Ranking. Stellen wir uns folgende Situation vor: wir wollen ein Rundholz kürzen. Greifen wir in unserer Toolbox zum Akkuschrauber, wird der Erfolg unseres Vorhabens begrenzt sein. Wählen wir hingegen eine Säge, sind unsere Chancen deutlich besser. Hier würde uns auch eine Metallsäge ans Ziel führen. Das beste Ergebnis können wir aber vermutlich nur mit der passenden Holzsäge erwarten. Doch selbst die beste Holzsäge sägt nicht allein und wenn unsere Hand die Säge nicht richtig führt, haben wir am Ende einen schiefen Schnitt.

Das Gedankenspiel mit dem Rundholz lässt sich auch auf die eingangs gestellte Frage und die Suche nach dem besten KI-Hilfsmittel übertragen.

Wir brauchen nicht unbedingt das „beste“ KI-Tool in der Rangliste, sondern das, was für die konkrete Aufgabe geeignet ist und dazu die Fähigkeiten, es zielbringend einzusetzen.

Bereits heute unterstützen Anbieter die Nutzer:innen beim ersten Teil, der Suche nach dem geeigneten KI-Tool. OpenAI beispielsweise lässt mittlerweile den KI-Assistenten entscheiden, welches Modell die Anfrage bearbeitet.

Der zweite Baustein für ein gelungenes KI-Erlebnis ist ein gut gestalteter Prompt. Er liegt (noch) in den Händen der Nutzer:innen. Ein guter Prompt, so scheint es, liefert bei den verbreiteten LLM brauchbare Ergebnisse.

In aller Kürze bedeutet dies: Bei der Nutzung etablierter LLM lohnt sich die Arbeit am Prompt mehr als die Suche nach einem besseren KI-Tool. Experimentierfreudige KI-Nutzer:innen werfen einen Blick auf die LMArena, um den für ihre Aufgabe am besten geeigneten KI-Assistenten zu identifizieren.